Leer la mente a través de la tecnología ya no es ciencia ficción. Este lunes, un equipo de investigadores de la Universidad de Texas, liderado por Jerry Tang y Alex Huth, publicó un avance de su trabajo en el que consiguió captar el sentido de lo pensado y la interpretación de la mente humana a través una herramienta de la inteligencia artificial sin necesidad de utilizar implantes cerebrales.

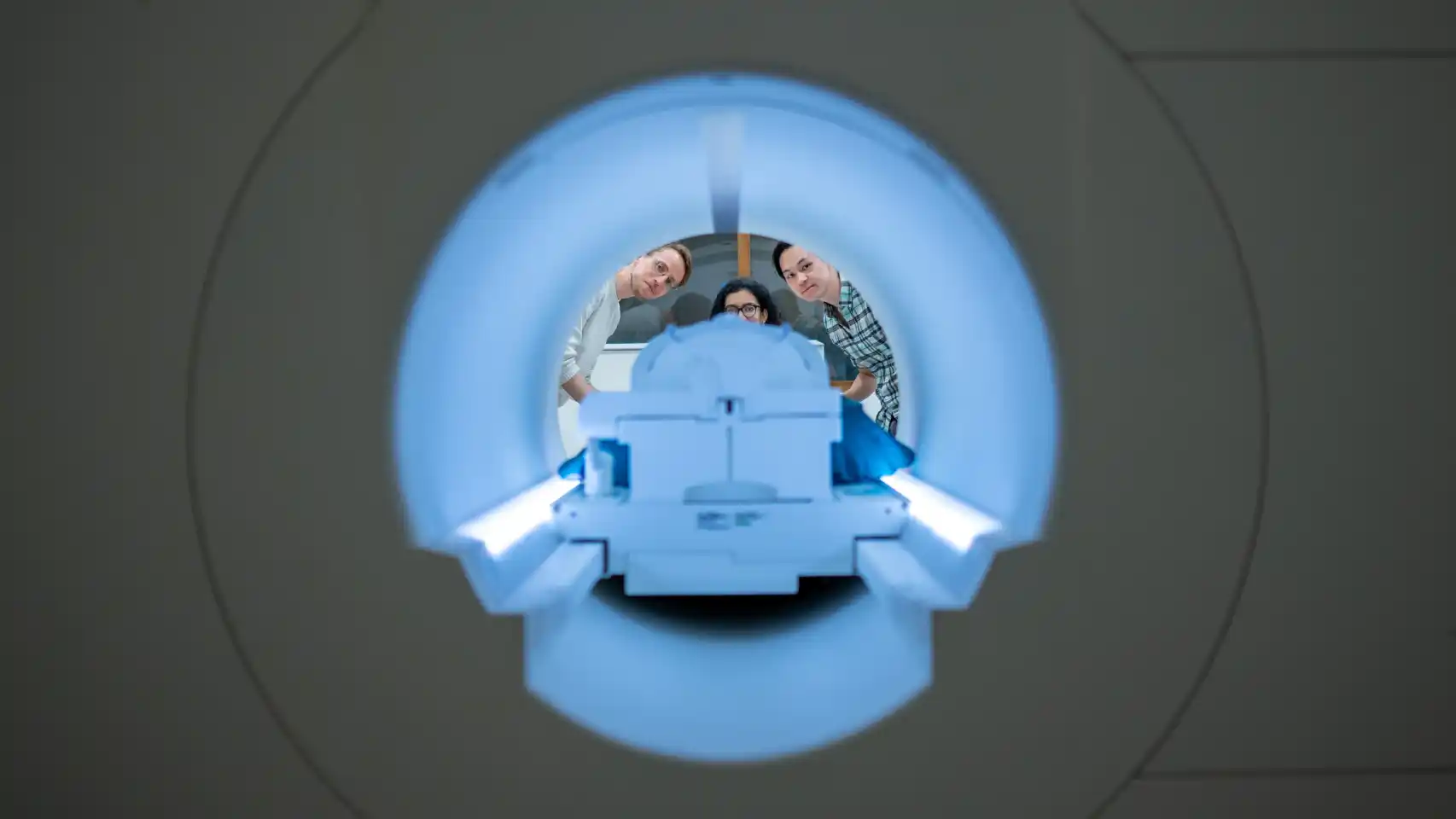

El estudio fue publicado en un artículo en la revista Nature Neuroscience este lunes y realiza la descripción del experimento, en el que los participantes estuvieron echados dentro de un escáner escuchando podcast durante 15 horas para entrenar la inteligencia artificial y, luego, se les mostraron cuatro videos.

MIRA: La Inteligencia Artificial podría empezar a obtener consciencia, advierten los expertos

La herramienta, denominada por ellos como “decodificador semántico”, fue capaz de describir de forma ajustada la historia de lo que el participante observaba o imaginaba. Esto fue contando durante la mitad del tiempo total del experimento aproximadamente.

Como muestra de esto, la frase de un voluntario fue “no sabía si gritar, huir o llorar; en vez de eso, ¡déjame en paz!”. La máquina lo tradujo en “empezó a gritar y llorar. Entonces, ella dijo `te dije que me dejaras en paz”. El decodificador semántico también pudo verbalizar lo que pensaban, pero sobre todo lo que pasaba por la cabeza de los participantes del estudio americano.

Las personas que fueron parte del experimento escucharon un podcast del New York Times y monólogos de un popular programa de radio The Moth Radio Hour, mientras les escaneaban la actividad cerebral mediante escáneres fMRI.

El escáner cerebral no es invasivo, pues utiliza un gorro lleno de electrodos. De esta forma, envía la información a un decodificado que convierte las gráficas no solo en frases completas, sino en textos que reproducían con gran fidelidad lo que habían visto u oído.

“Nos sorprendió un poco que funcione tan bien como lo hace. He estado trabajando en esto por 15 años y fue emocionante cuando al final funcionó”, declaró Huth, el neurocientífico que dirigió el trabajo en la Universidad de Texas, en una rueda de prensa virtual. “Se trata del GPT original, no como el nuevo [ChatGPT se apoya en la última versión de GPT, la 4]. Recopilamos una tonelada de datos y luego construimos este modelo, que predice las respuestas cerebrales a las historias”, completó

VIDEO RECOMENDADO